보스가 알려줘서 읽은 논문(에세이?)을 소개한다. 두 저자 모두 마이크로소프트연구소(Microsoft Research) 연구원인데, 그 중 다나 보이드(danah boyd)는 뉴욕대 연구교수이며 케이트 크로포드(Kate Crawford)는 뉴사우스웨일즈대학교 교수다. 논문 제목은 "빅데이터에 관한 비판적 질문들(Critical questions for Big Data)"이다.

빅데이터(한국말로 큰자료)는 점점 더 유행이 되는 모습이다. 트위터와 페이스북으로 대표되는 대용량 실시간 고해상도;; 데이터라든지, 우리 그룹에서도 연구해온 수백만명의 핸드폰 통화/문자 데이터라든지 하는 것들이 빅데이터로 불린다. 이런 데이터에 관한 연구도 활발히 이루어지고 있고 그전까지 볼 수 없었던 다양한 측면들을 볼 수 있게 되었다. 분명 새로운 현상이지만 또한 이런 연구 흐름이 가져올 문제들을 짚어볼 필요도 있다. 이 논문은 그런 몇 가지 중요한 질문을 던진다.

원래 빅데이터는 수퍼컴퓨터가 필요할 정도로 큰 데이터를 가리켰다고 한다. 하지만 기술이 발달해서 그 '크기'만으로 빅데이터를 정의하는 건 더이상 적절하지 않다. 그보다는 데이터를 찾고 모으고 분석하는데 필요한 용량에 관한 개념으로 봐야 한다고 한다. 저자들은 기술, 분석, 신화의 상호작용에 기반한 문화, 기술, 학문적 현상으로 빅데이터를 정의한다.

1) 기술: 큰 데이터를 모으고 분석하고 연결하고 비교하기 위해 계산능력과 알고리즘의 정확성을 최대화하기

2) 분석: 경제, 사회, 기술, 법적 주장을 하기 위해 데이터로부터 패턴을 찾아내기

3) 신화: 큰 데이터가 진실, 객관성, 정확성의 아우라로 이전에 불가능했던 더 높은 형태의 지능과 지식을 제공할 거라는 널리 퍼진 믿음

여튼, 이제 질문을 시작한다.

1. 빅데이터는 지식의 정의를 바꾼다.

헨리 포드가 자동화된 공정을 도입함으로써 생산의 개념을 바꾸었듯이 빅데이터도 데이터를 모으고 분석하는 새로운 방법론에 따라 학자들이 연구에 대해 생각하는 방식을 바꾼다고 한다. 그런데 더 구체적인 얘기는 별로 없다. 관련해서 마침 내가 엊그제 간단히 정리한 크리스 앤더슨의 글을 인용한다. "충분히 큰 데이터가 있다면, 숫자가 스스로 말할 것이다"라고 한 앤더슨의 주장에 '아니'라고 하는데, 모든 도구/방법에는 그 한계가 있기 때문에 이를 제대로 알아야 한다는 것 같다. 더 구체적인 반론은 다음 장에서 다루어진다.

2. 객관성과 정확성에 관한 주장은 오해를 불러일으킨다.

데이터 양이 많다는 게 더 객관적이라는 걸 뜻하지 않는다. 실제로 빅데이터 연구는 여전히 주관적이다. 내 경험에 비추어봐도 데이터가 아무리 많아도 연구 주제나 질문에 따라 얼마든지 다른 양을 잴 수 있고 그런 '양'을 정의하는 순간 이미 나의 주관이 개입된다. 한 사람이 얼마나 많은 돈을 가졌는지와 그 돈을 어떻게 쓰는지는 별개의 문제인 것처럼 말이다. 물론 돈의 양이 그 쓰임새에 영향을 주는 것처럼, 데이터도 그렇다. 과거에 데이터가 너무 적어서 어쩔 수 없이 특별한 가정을 해야 했었다면, 이제는 데이터가 많아서 그런 특별한 가정을 하지 않아도 된다는 면에서 분명 상황이 나아졌다고 볼 수 있다.

저자들은 정성/정량 연구의 구분이 '정성적 해석'과 '정량적 사실'로 귀결되는 것은 아니라고도 한다. 이 얘기는 딱 와닿지는 않지만 생각해볼 거리가 있는 것 같다.

같은 맥락에서, 모든 연구자는 데이터를 해석하는 사람이라고 한다. 계산과학자들이 수학적으로 안전한 모형을 만들고 그 실험이 유효해보여도 그들이 그 '의미'를 이해하고자 하는 순간 해석을 피할 수 없다고 한다. 또한 데이터는 기본적으로 더럽기에(오류 등) 깨끗하게 해주는 과정(data cleaning)이 필요한데 여기에도 이미 주관이 개입된다.

데이터가 수집되는 과정에도 편향이 있다. 그래서 늘 데이터의 성질과 한계에 대한 이해가 기본이 되어야 한다.

3. 더 큰 데이터가 언제나 더 좋은 데이터는 아니다.

해석에서 편향의 문제, 실험 설계에서 조절과 표준화의 문제, 설문조사에서 질문에 의한 편향 문제, 통계적 유의성 등 데이터 분석이 타당한지를 판가름하는 많은 방법들이 있다. 데이터가 많다고, 즉 빅데이터라고 이런 방법론적 문제가 더이상 중요하지 않은 것은 아니다.

예를 들어, 트위터의 경우 대개 연구자들은 '수백만명의 사람들'을 연구했다고 하는데, '트위터 계정들'과 '사람들'은 동의어가 아니다. 한 사람이 여러 계정을 갖고 있기도 하고 여러 사람이 한 계정을 이용하기도 하며, '활동적인' 계정을 어떻게 정의하느냐 문제도 있다. 또한 데이터의 소스가 불확실할 때 예(샘플)를 이해하는 건 어렵다. 즉 데이터가 어떤 기준으로 모아졌느냐에 따라 그 해석이 달라질 수밖에 없는데 이런 요인을 염두에 두어야 한다.

덧붙여, 빅데이터뿐 아니라 작은 데이터를 제대로 이해하는 것도 중요하다. 여전히 작은 데이터, 심지어 단 1명의 연구대상을 제대로 이해함으로써 그 연구분야에 큰 기여를 할 수도 있다.

4. 맥락이 무시된 빅데이터는 그 의미를 잃는다.

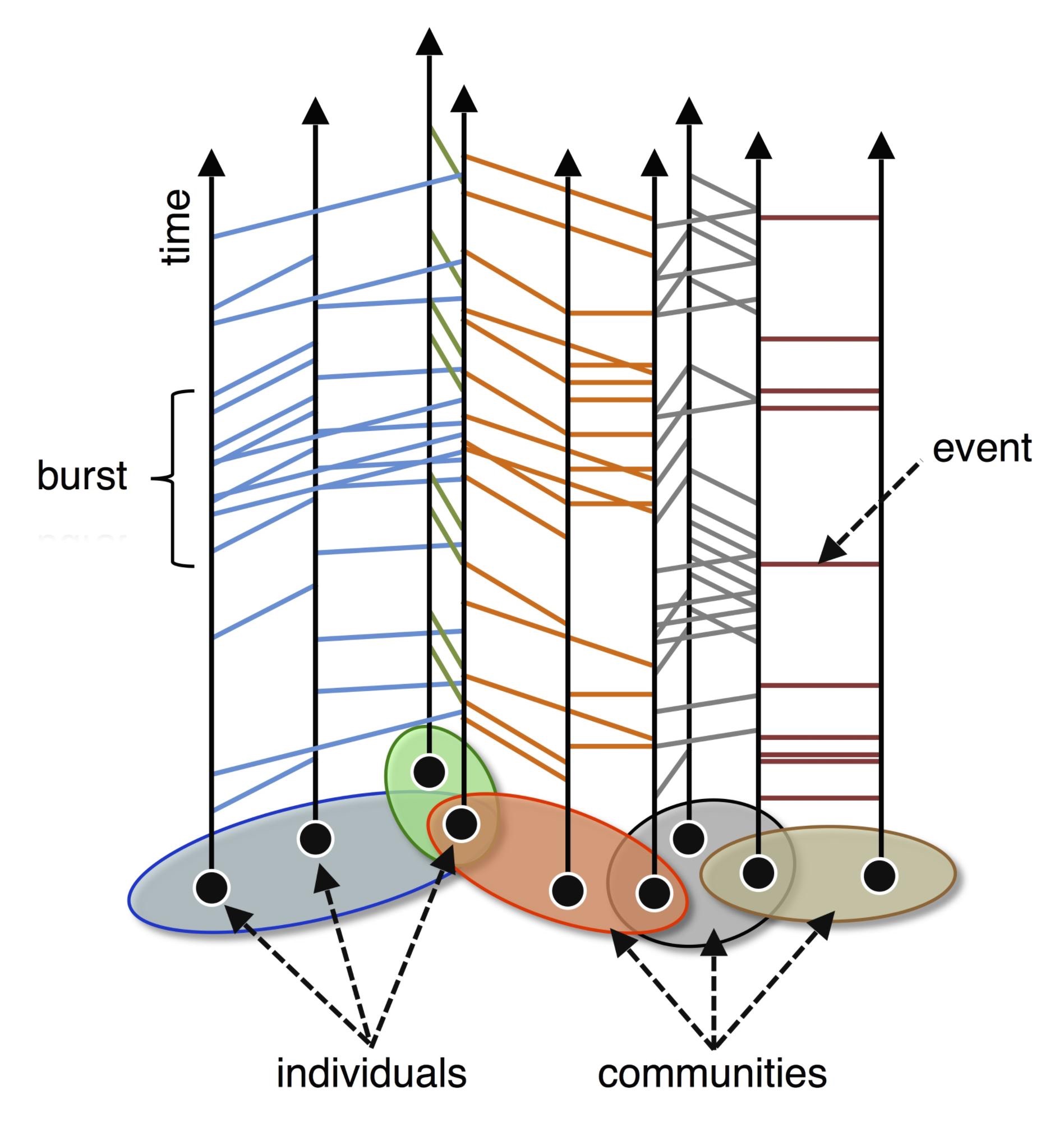

빅데이터는 사회연결망의 두 가지 새로운 형태를 제시한다. 표현연결망(articulated networks)과 행동연결망(behavioral networks)이다. 표현연결망은 사람들이 그들의 이웃/관계를 이메일 주소록이나 트위터 팔로워 목록 같은 기술적 메커니즘을 통해 표현한 결과다. 여기에는 친구, 지인 뿐 아니라 유명인, 친구의 친구 등이 포함된다. 행동연결망은 문자를 주고받거나 전화를 걸고 받는 등의 실제 소통패턴으로부터 나온다.

이 두 연결망은 동등하지 않으며, 모든 연결이 다 동등하지도 않다. 연락횟수가 관계의 세기를 가리키지 않는 경우도 있다. 이런 문제들은 그 맥락을 고려할 때에만 제대로 이해될 수 있다고 저자들은 주장하는 것으로 보인다.

5. 접근할 수 있다고 해서 윤리적인 건 아니다.

이 장의 제목 그대로, 어떤 트위터 계정이 공개되어 있다고 해서 본인의 동의 없이 그 내용을 모아서 연구해도 된다는 걸 뜻하지 않는다. 길거리에 얼굴을 내놓고 다닌다고, 즉 누구나 내 얼굴을 볼 수 있다고 해도 그게 아무나 내 얼굴 사진을 찍어서 연구해도 되는 건 아니라는 것과 같다. 물론 딱 정해진 기준도 없고 누가 강제할 수도 없지만 연구자들이 늘 염두에 두고 연구윤리에 관해 고민해야 한다고 한다.

6. 빅데이터에 대한 접근의 제한은 새로운 디지털 분절(divide)을 만든다.

마노비치가 2011년에 지적했듯이, "사회매체회사들만이 정말 큰 사회데이터에 접근할 수 있다. 페이스북을 위해 일하는 인류학자나 구글을 위해 일하는 사회학자는 다른 연구자들이 접근할 수 없는 데이터에 접근하게 될 것이다." 이런 데이터에 접근할 수 없으면 특권을 가진 연구자들의 방법론적 주장을 재생산하거나 평가할 수 없다. 또한 그런 데이터에 접근할 수 있는 연구자들도 데이터를 제공하는 회사의 눈치를 볼 수밖에 없다.

그리고 데이터 분석기술을 가졌느냐도 중요한데, 이런 기술이 없는 연구자는 이런 기술을 가진 연구자에 비해 빅데이터에 대한 접근이 제약될 거고 이는 디지털 분절을 강화할 것이다. 저자들은 여기에 성별에 따른 분절를 언급하면서 저런 기술을 가진 대부분 연구자들이 남성이라고 지적한다.

이런 분절은 '빅데이터 리치'와 '빅데이터 푸어'를 만들어낸다고 한다. 즉 빅데이터를 연구할 수 있는 사람과 그렇지 못하는 사람의 분절이다. 관련하여, "산업이 더 잘 할 수 있는 분야를 학계가 연구할 필요는 없다"고 트위터에서 안식년을 보내는 교수가 주장했다고 한다. 물론 이런 주장은 연구공동체의 토대를 약하게 만든다.

마지막으로 빅데이터는 학계에서만 연구하는 게 아니라 실은 정부, 기업 등이 이미 이런 연구를 많이 이끌고 있으며 그만큼 실질적인 영향을 행사할 수 있다.

---

여기까지 정리를 하면서, 나도 데이터 연구를 하면서 때론 매우 직접적으로, 때론 막연하게 갖고 있던 데이터 연구의 문제점들을 분명하게 해볼 수 있었다. 끝.